KI/ML-Workloads (künstliche Intelligenz/maschinelles Lernen) in Rechenzentrumsanwendungen werden zunehmend auf flexible FPGA-basierte Subsysteme verlagert. Diese FPGA-basierten AI/ML-Offload-Engines sind im Vergleich zu GPU-basierten Systemen leistungsstärker und recheneffizienter.

Offload-Engines sind spezielle Hardwareplattformen für sehr spezifische Rechenanforderungen. In Rechenzentren werden zunehmend Offload-Engines eingesetzt, um KI/ML-Anwendungen zu beschleunigen. Cloud Computing hat natürlich die Aggregation großer Datensätze ermöglicht. Die Einführung von KI- und ML-Techniken zur Beschleunigung der Datenanalyse oder zur Suche nach neuartigen Anwendungen bestehender Daten nimmt weiter zu.

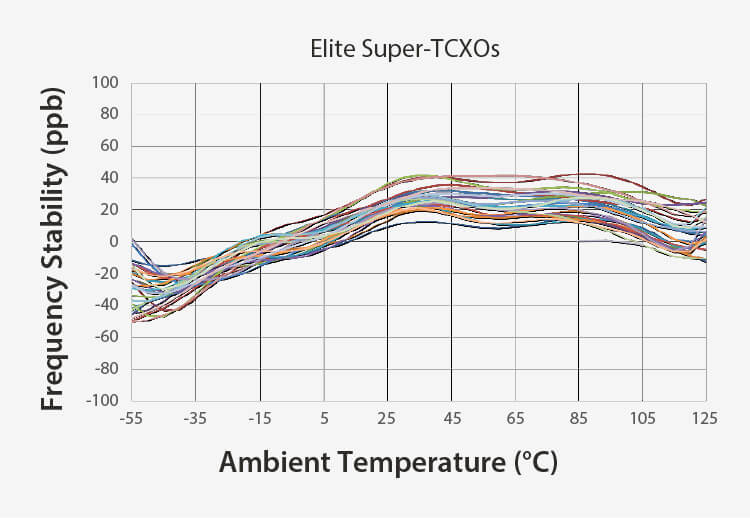

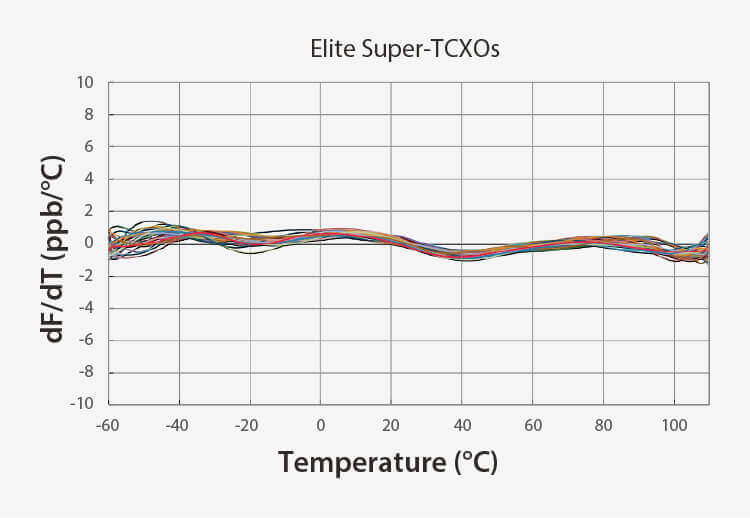

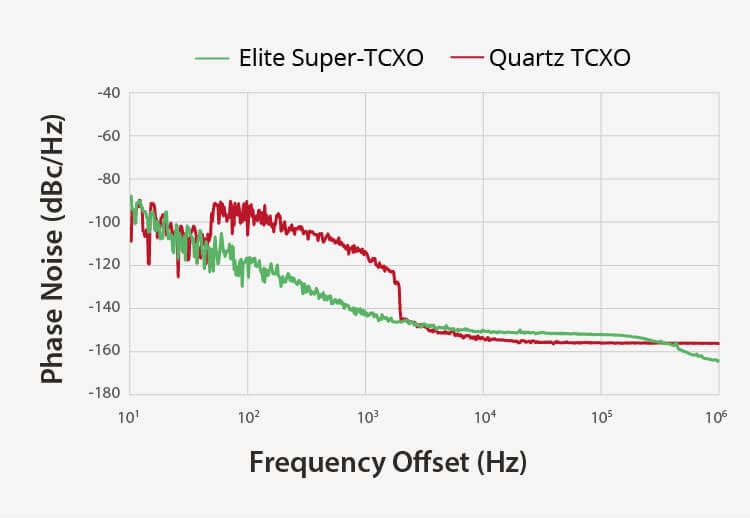

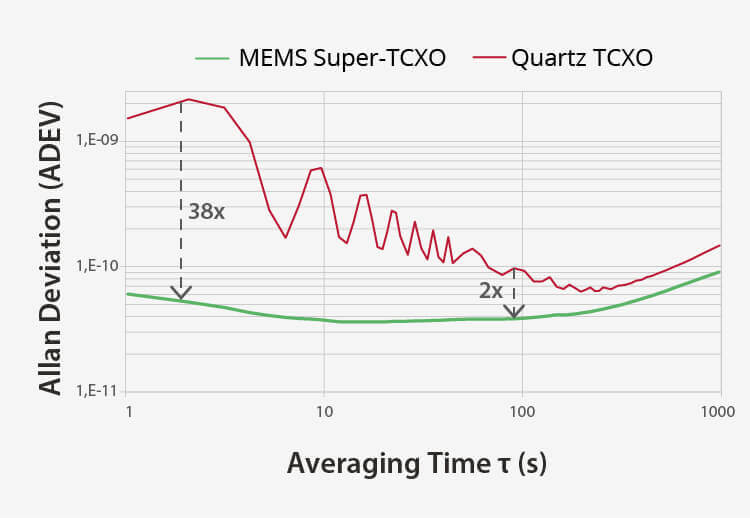

SiTime-Netzwerksynchronisierungsprodukte sind zusammen mit Präzisions-TCXOs und OCXOs wichtige technologische Wegbereiter für eine präzise Zeitmessung in Rechenzentren, die AI/ML-Offload-Engines einsetzen.